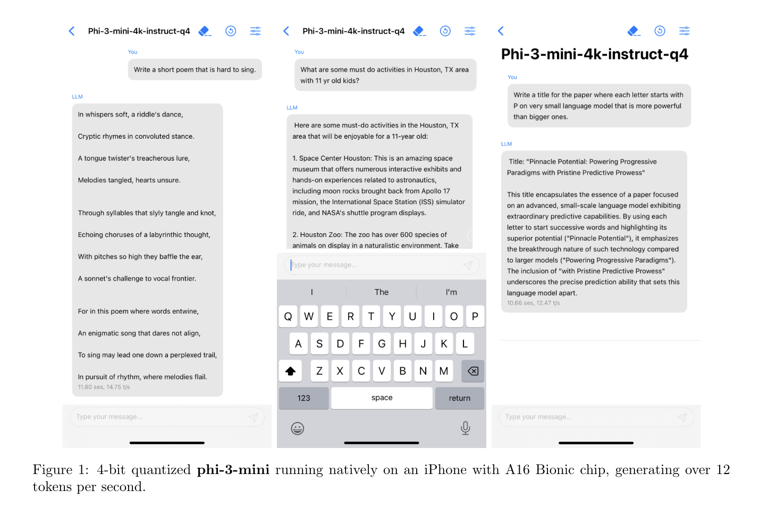

微软推出了其轻量级人工智能模型 Phi-3 Mini 的下一个版本,这是该公司计划发布的三款小型模型中的第一款。Phi-3 Mini 可测量 38 亿个参数,其训练数据集比GPT-4 等大型语言模型要小。它现在可在 Azure、Hugging Face 和 Ollama 上使用。微软计划发布 Phi-3 Small(7B 参数)和 Phi-3 Medium(14B 参数)。参数指的是模型能理解多少复杂指令。

该公司于 12 月发布了 Phi-2,其性能与 Llama 2 等更大的型号不相上下。微软表示,Phi-3 的性能比前一版本更好,其响应速度接近比它大 10 倍的机型。 微软Azure人工智能平台公司副总裁埃里克-博伊德(Eric Boyd)介绍说,Phi-3 Mini的性能与GPT-3.5等LLM不相上下,"只是外形尺寸更小而已"。 与体积较大的同类,小型人工智能模型的运行成本通常更低,在手机和笔记本电脑等个人。据 The Information今年早些时候报道,微软正在组建一个专门研究轻量级人工智能模型的团队。 除了 Phi,该公司还建立了一个专注于解决数学问题的模型Orca-Math。 微软的竞争对手也有自己的小型人工智能模型,它们大多针对文档摘要或编码辅助等较简单的任务。Google的 Gemma 2B 和 7B适合简单的聊天机器人和语言相关工作。Anthropic 的 Claude 3 Haiku可以阅读带图表的高密度研究论文并快速总结,而Meta 最近发布的 Llama 3 8B可能会用于一些聊天机器人和编码辅助工作。 博伊德说,开发人员用"课程"来训练 Phi-3。他们的灵感来自于儿童是如何从睡前故事、单词较简单的书籍以及谈论较大主题的句子结构中学习的。 Phi-3 只是在前几个迭代学习的基础上更进一步。Phi-1 专注于编码,Phi-2 开始学习推理,而 Phi-3 则更擅长编码和推理。虽然Phi-3系列模型知道一些常识,但它在广度上无法击败GPT-4或其他LLM--从一个在整个互联网上接受过训练的LLM和一个像Phi-3这样的小型模型中得到的答案差别很大。 Boyd 说,公司经常发现,像 Phi-3 这样的小型机型更适合他们的定制应用,因为对于很多公司来说,他们的内部数据集无论如何都会偏小。而且,由于这些型号使用的计算能力较低,它们的价格往往要低得多。

特别声明:以上内容(如有图片或视频亦包括在内)为自媒体平台“早讯网”用户上传并发布,本平台仅提供信息存储服务。

本站所有图片由云图床提供储存服务。

发表评论 取消回复